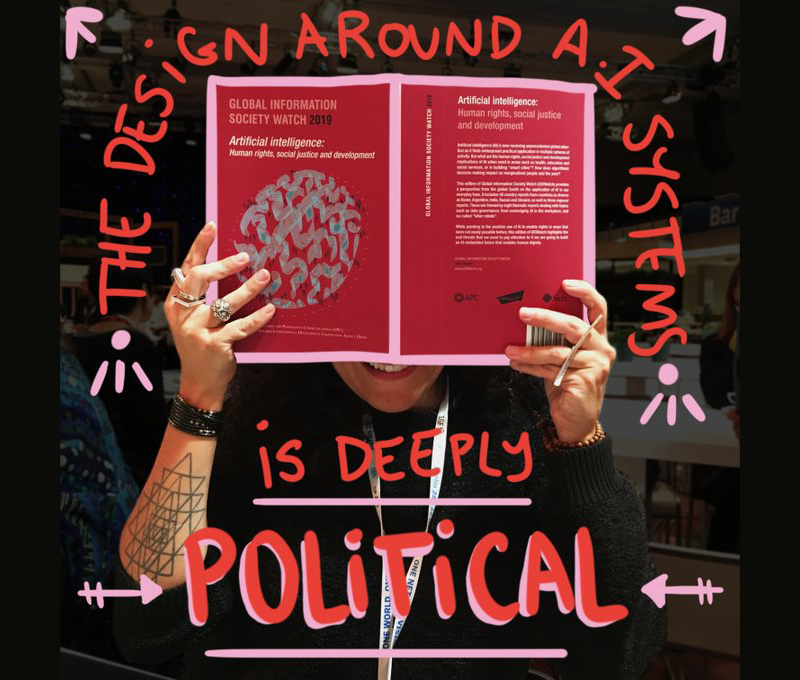

Το Rising Voices (RV) συνεργάζεται με την Ένωση Προοδευτικών Επικοινωνιών (APC) [2], η οποία δημιούργησε το Παρατηρητήριο της Παγκόσμιας Κοινωνίας της Πληροφορίας του 2019 (GISWatch) με θέμα την Τεχνητή Νοημοσύνη (ΤΝ): Ανθρώπινα Δικαιώματα, Κοινωνική Δικαιοσύνη και Ανάπτυξη. Κατά τους προσεχείς μήνες, το RV θα αναδημοσιεύσει κείμενα χωρών, ιδιαίτερα όσα υπογραμμίζουν τον τρόπο, με τον οποίο η ΤΝ μπορεί να επηρεάσει ιστορικά υποεκπροσωπούμενες ή περιθωριοποιημένες κοινότητες.

Αυτή η ανάρτηση [3] γράφτηκε από τους Paz Peña [4] και Joana Varon [5] από το Coding Rights [6]. Αυτή η αναφορά δημοσιεύθηκε αρχικά ως μέρος της ευρύτερης συλλογής: “Παρατηρητήριο της Παγκόσμιας Κοινωνίας της Πληροφορίας του 2019: Τεχνητή νοημοσύνη: Ανθρώπινα Δικαιώματα, Κοινωνική Δικαιοσύνη και Ανάπτυξη”. Επισκεφτείτε τον ιστότοπο GISWatch [7] για το πλήρες κείμενο, το οποίο είναι επίσης διαθέσιμο με άδεια CC BY 4.0.

Ας υποθέσουμε ότι έχετε πρόσβαση σε μια βάση δεδομένων με πληροφορίες από 12.000 κορίτσια και νέες γυναίκες ηλικίας 10 έως 19 ετών, που είναι κάτοικοι κάποιας φτωχής επαρχίας στη Νότια Αμερική. Τα σύνολα δεδομένων περιλαμβάνουν την ηλικία, τη γειτονιά, την εθνικότητα, τη χώρα προέλευσης, το εκπαιδευτικό επίπεδο του αρχηγού του νοικοκυριού, τις σωματικές και διανοητικές αναπηρίες, τον αριθμό των ατόμων, που μοιράζονται ένα σπίτι, και το εάν έχουν ή όχι στη διάθεσή τους ζεστό νερό. Ποια συμπεράσματα θα αντλήσετε από μια τέτοια βάση δεδομένων; Ή ίσως το ερώτημα πρέπει να είναι: Είναι ακόμη και επιθυμητό να βγάλουμε κάποιο συμπέρασμα; Μερικές φορές, και δυστυχώς συνήθως, απλά η δυνατότητα εξαγωγής μεγάλων ποσοτήτων δεδομένων είναι μια αρκετά καλή δικαιολογία για να “τους κάνει να μιλήσουν” και, το χειρότερο από όλα, να αποφασίζουν με βάση αυτά.

Η βάση δεδομένων, που περιγράφεται παραπάνω, είναι πραγματική. Και χρησιμοποιείται από τις δημόσιες Αρχές για την πρόληψη της εγκατάλειψης του σχολείου και της εφηβικής εγκυμοσύνης. “Οι ευφυείς αλγόριθμοι μας επιτρέπουν να εντοπίζουμε χαρακτηριστικά σε άτομα, που θα μπορούσαν να καταλήξουν σε αυτά τα προβλήματα και να προειδοποιήσουμε την κυβέρνηση να εργαστεί για την πρόληψή τους”, δήλωσε [8] εκπρόσωπος της Microsoft Azure. Η εταιρεία είναι υπεύθυνη για το σύστημα εκμάθησης μηχανών, που χρησιμοποιείται στην Τεχνολογική Πλατφόρμα για την Κοινωνική Παρέμβαση, που δημιουργήθηκε από το Υπουργείο Πρώιμης Παιδικής Μέριμνας της επαρχίας Σάλτα της Αργεντινής.

“Με την τεχνολογία, με βάση το όνομα, το επώνυμο και τη διεύθυνση, μπορείτε να προβλέψετε πέντε ή έξι χρόνια μπροστά ποια κοπέλα ή μελλοντική έφηβη είναι 86% προκαθορισμένη για εφηβική εγκυμοσύνη”, δήλωσε [9] ο Juan Manuel Urtubey, συντηρητικός πολιτικός και κυβερνήτης της Σάλτα. Το Υπουργείο Πρώιμης Παιδικής Μέριμνας της επαρχίας εργάστηκε για χρόνια [10] με την ΜΚΟ για την καταπολέμηση των αμβλώσεων, Fundación Conin, ώστε να προετοιμάσει αυτό το σύστημα [11]. Η δήλωση του Urtubey έγινε στη μέση μιας εκστρατείας για νόμιμη έκτρωση στην Αργεντινή το 2018, η οποία προήλθε από ένα κοινωνικό κίνημα για τα σεξουαλικά δικαιώματα, το οποίο βρισκόταν στην πρώτη γραμμή της δημόσιας συζήτησης σε τοπικό επίπεδο και έλαβε μεγάλη διεθνή προσοχή [12]. Η ιδέα ότι οι αλγόριθμοι μπορούν να προβλέψουν την εφηβική εγκυμοσύνη, προτού αυτή συμβεί, είναι η τέλεια δικαιολογία για τους ακτιβιστές εναντίον των γυναικείων δικαιωμάτων [13] και της σεξουαλικής απελευθέρωσης και τους ακτιβιστές ενάντια στα αναπαραγωγικά δικαιώματα για να δηλώσουν ότι οι νόμοι περί άμβλωσης είναι περιττοί. Σύμφωνα με τις αφηγήσεις τους, εάν έχουν επαρκείς πληροφορίες από φτωχές οικογένειες, μπορούν να αναπτυχθούν συντηρητικές δημόσιες πολιτικές για την πρόβλεψη και την αποφυγή αμβλώσεων από φτωχές γυναίκες. Επιπλέον, υπάρχει η πεποίθηση ότι “αν προτείνεται από έναν αλγόριθμο, είναι μαθηματικά, οπότε πρέπει να είναι αληθινό και αδιάψευστο”.

Είναι επίσης σημαντικό να επισημάνουμε ότι η βάση δεδομένων που χρησιμοποιείται στην πλατφόρμα έχει μόνο δεδομένα σχετικά με τα θηλυκά. Αυτή η συγκεκριμένη εστίαση σε ένα συγκεκριμένο φύλο ενισχύει τους πατριαρχικούς ρόλους των φύλων και, τελικά, κατηγορεί τις έφηβες για ανεπιθύμητες εγκυμοσύνες, λες και θα μπορούσε ένα παιδί να συλληφθεί χωρίς σπέρμα.

Για αυτούς τους λόγους, και για άλλους, η Τεχνολογική Πλατφόρμα για την Κοινωνική Παρέμβαση έχει λάβει πολλές επικρίσεις. Κάποιοι αποκάλεσαν το σύστημα “ψέμα”, “ψευδαίσθηση” και “νοημοσύνη που δεν σκέφτεται” και είπαν [9] ότι τα ευαίσθητα δεδομένα των φτωχών γυναικών και παιδιών διατρέχουν κίνδυνο. Μια πολύ πλήρη τεχνική ανάλυση των αποτυχιών του συστήματος δημοσιεύθηκε από το Εργαστήριο Εφαρμοσμένης Τεχνητής Νοημοσύνης (LIAA) στο Πανεπιστήμιο του Μπουένος Άιρες. Σύμφωνα με το LIAA, το οποίο ανέλυσε τη μεθοδολογία και δημοσιεύτηκε στο GitHub [14] από έναν μηχανικό της Microsoft, τα αποτελέσματα υπερεκτιμήθηκαν λόγω στατιστικών λαθών στη μεθοδολογία. Η βάση δεδομένων διαπιστώθηκε επίσης ότι είναι προκατειλημμένη λόγω των αναπόφευκτων ευαισθησιών της αναφοράς ανεπιθύμητων εγκυμοσυνών, και τα δεδομένα είναι ανεπαρκή για να κάνουν αξιόπιστες προβλέψεις.

Παρ’ όλα αυτά, η πλατφόρμα συνέχισε να χρησιμοποιείται. Ακόμη χειρότερα, οι κακές ιδέες που παρουσιάστηκαν ως καινοτομία εξαπλώθηκαν γρήγορα: το σύστημα αναπτύσσεται τώρα σε άλλες επαρχίες της Αργεντινής [15], όπως η Λα Ριόχα, η Γη του Πυρός και η Chaco, και εξάγεται στην Κολομβία και εφαρμόζεται στο δήμο Λα Γκουατζίρα [16].

Η Τεχνολογική Πλατφόρμα για την Κοινωνική Παρέμβαση είναι ένα πολύ σαφές παράδειγμα του τρόπου με τον οποίο οι λύσεις τεχνητής νοημοσύνης (ΑΙ), τις οποίες όπως υποστηρίζουν οι υπεύθυνοι υλοποίησής τους είναι ουδέτερες και αντικειμενικές, αναπτύσσονται όλο και περισσότερο σε ορισμένες χώρες της Λατινικής Αμερικής για να στηρίξουν δυνητικά προκατειλημμένες δημόσιες πολιτικές που υπονομεύουν τα ανθρώπινα δικαιώματα των μη προνομιούχων ανθρώπων. Όπως δείχνει η πλατφόρμα, αυτό περιλαμβάνει την παρακολούθηση και τη λογοκρισία των γυναικών και των σεξουαλικών και αναπαραγωγικών τους δικαιωμάτων.

Πιστεύουμε ότι μια από τις κύριες αιτίες για τέτοιες καταστροφικές χρήσεις της μηχανικής μάθησης και άλλων τεχνολογιών ΤΝ είναι μια τυφλή πίστη στη διαφημιστική εκστρατεία ότι τα μεγάλα δεδομένα θα λύσουν αρκετά φλέγοντα ζητήματα που αντιμετωπίζει η ανθρωπότητα. Αντ’ αυτού, προτείνουμε να οικοδομήσουμε μια τρανσφεμινιστική [17] κριτική και ένα πλαίσιο που να προσφέρει όχι μόνο την δυνατότητα να αναλύσει τις επιζήμιες επιπτώσεις της ΤΝ, αλλά και μια προληπτική κατανόηση για το πώς να φανταστείτε, να σχεδιάσετε και να αναπτύξετε μια χειραφετημένη ΤΝ που να υπονομεύει τον καταναλωτισμό, τον μισογυνισμό, τον ρατσισμό και τους ετεροπατριαρχικούς και με βάση την δυαδικότητα των φύλων κοινωνικούς κανόνες.

Μεγάλα δεδομένα για επίλυση προβλημάτων ή μεροληψία μεταμφιεσμένη σε μαθηματικά;

Η Τ.Ν. μπορεί να οριστεί σε γενικές γραμμές ως τεχνολογία, που κάνει προβλέψεις με βάση την αυτόματη ανίχνευση δεδομένων. Όπως και στην περίπτωση της κυβέρνησης της επαρχίας Σάλτα, πολλά κράτη σε όλο τον κόσμο χρησιμοποιούν όλο και περισσότερο αλγοριθμικά εργαλεία λήψης αποφάσεων για τον προσδιορισμό της διανομής αγαθών και υπηρεσιών, μεταξύ άλλων εκπαίδευσης, δημόσιων υπηρεσιών υγείας, αστυνόμευσης και στέγασης. Επιπλέον, τα προγράμματα καταπολέμησης της φτώχειας ελέγχονται από κυβερνήσεις και οι αλγόριθμοι χρησιμοποιούνται για τον προσδιορισμό των κοινωνικών παροχών για τους φτωχούς και τους άνεργους, μετατρέποντας την “ζωντανή εμπειρία της φτώχειας και της ευπάθειας σε μηχανικά αναγνώσιμα δεδομένα, με απτά αποτελέσματα στις ζωές και τα μέσα διαβίωσης των εμπλεκόμενων πολιτών.”

Η Cathy O'Neil, αναλύοντας τις χρήσεις της Τ.Ν. στις Ηνωμένες Πολιτείες (ΗΠΑ), ισχυρίζεται ότι πολλά συστήματα ΤΝ “τείνουν να τιμωρούν τους φτωχούς”. Εξηγεί:

Αυτό συμβαίνει, εν μέρει, επειδή έχουν σχεδιαστεί για την αξιολόγηση μεγάλου αριθμού ανθρώπων. Ειδικεύονται σε χύμα, και είναι φτηνές. Αυτό είναι μέρος της γοητείας τους. Οι πλούσιοι, αντίθετα, συχνά επωφελούνται από προσωπικές εισροές. […] Οι προνομιούχοι, θα δούμε ξανά και ξανά, ότι επεξεργάζονται περισσότερο από ανθρώπους, οι μάζες από μηχανές.

Τα συστήματα ΤΝ βασίζονται σε μοντέλα που είναι αφηρημένες αναπαραστάσεις, οικουμενικές και απλοποιήσεις σύνθετων πραγματικοτήτων, όπου πολλές πληροφορίες έχουν εξαλειφθεί σύμφωνα με την κρίση των δημιουργών τους. Η O'Neil παρατηρεί:

Τα μοντέλα, παρά τη φήμη τους για αμεροληψία, αντικατοπτρίζουν τους στόχους και την ιδεολογία. […] Οι δικές μας αξίες και επιθυμίες επηρεάζουν τις επιλογές μας, από τα δεδομένα που επιλέγουμε να συλλέξουμε στις ερωτήσεις που θέτουμε. Τα μοντέλα είναι απόψεις που ενσωματώνονται στα μαθηματικά.

Σε αυτό το πλαίσιο, η ΤΝ θα αντικατοπτρίζει τις αξίες των δημιουργών της και έτσι πολλοί επικριτές εστίασαν στην αναγκαιότητα της πολυμορφίας και της συμμετοχής:

Έτσι, τα ζητήματα της συμμετοχικότητας [18] – από το ποιος το σχεδιάζει μέχρι ποιοι συμμετέχουν στα διοικητικά συμβούλια της εταιρείας και ποιες ηθικές προοπτικές συμπεριλαμβάνονται. Διαφορετικά, διακινδυνεύουμε να κατασκευάσουμε μια μηχανική νοημοσύνη που να αντικατοπτρίζει ένα στενό και προνομιούχο όραμα της κοινωνίας, με τις παλιές, γνωστές προκαταλήψεις και στερεότυπα.

Αλλά η πολυμορφία και η συμπερίληψη δεν αρκούν για να δημιουργήσουν μια χειραφετημένη ΤΝ. Αν ακολουθήσουμε τις ιδέες του Μαρκούζε [19] ότι “ο τεχνολογικός τρόπος παραγωγής είναι μια συγκεκριμένη μορφή ή σύνολο συνθηκών που η κοινωνία μας έχει πάρει μεταξύ άλλων πιθανών συνθηκών και αυτός ο τρόπος παραγωγής έχει τον τελικό ρόλο στη διαμόρφωση τεχνικών, την εξάπλωση και τη διάδοσή τους”, είναι θεμελιώδους σημασίας η βαθιά κατάδυση σε αυτά, που αποτελούν το κυρίαρχο συμφέρον αυτού του ιστορικοκοινωνικού έργου. Υπό αυτή την έννοια, οι θεωρίες της δικαιοσύνης των δεδομένων [20] αντανακλούσαν την ανάγκη να συνδεθεί ρητά μια ατζέντα κοινωνικής δικαιοσύνης με την επανάσταση των δεδομένων, που υποστηρίζουν ορισμένα κράτη, εταιρείες και διεθνείς οργανισμοί, προκειμένου να επιτευχθεί δίκαιη μεταχείριση των πολιτών από το κράτος και από τον ιδιωτικό τομέα, ή όταν ενεργούν από κοινού.

Για παράδειγμα, όπως το πλαισιώνει η Payal Arora, οι συζητήσεις γύρω από τα μεγάλα δεδομένα έχουν μια συντριπτικά θετική συνύπαρξη χάρη στη νεοφιλελεύθερη ιδέα ότι η εκμετάλλευση για κέρδος των δεδομένων των φτωχών από ιδιωτικές εταιρείες θα ωφελήσει μόνο, τον πληθυσμό. Αυτό είναι, από πολλές απόψεις, το σημάδι ότι υπάρχουν δύο παλιές γνώριμες, ο καπιταλισμός και η αποικιοκρατία, είναι παρόντες και υγιείς κάθε φορά που ένα σύστημα ΤΝ γδύνει τους ανθρώπους από την αυτονομία τους και τους αντιμετωπίζει “ως απλά ακατέργαστα δεδομένα για επεξεργασία [21]“. Στο ίδιο πνεύμα, οι Couldry και Mejias θεωρούν ότι η οικειοποίηση και εκμετάλλευση δεδομένων για αξία έχει βαθιές ρίζες στον καπιταλισμό και την αποικιοκρατία.

Πρόσφατα, συνδέοντας αυτή την κριτική με τη φυλετικοποίηση των πολιτών και των κοινοτήτων μέσω αλγοριθμικών αποφάσεων, η Safiya Umoja Noble έχει επεξεργαστεί τον όρο “τεχνολογική πρακτική της κόκκινης γραμμής”, η οποία αναφέρεται στη διαδικασία διάκρισης δεδομένων που ενισχύει την ανισότητα και την καταπίεση. Ο όρος βασίζεται στην πρακτική [22] “της κόκκινης γραμμής” στις ΗΠΑ, με την οποία οι κοινότητες υφίστανται συστηματική άρνηση διαφόρων υπηρεσιών είτε άμεσα είτε μέσω της επιλεκτικής αύξησης των τιμών βάσει της φυλής τους:

Πιστεύω ότι οι έγχρωμοι άνθρωποι θα το βιώνουν ολοένα και περισσότερο ως θεμελιώδη διάσταση δημιουργίας, διατήρησης ή εμβάθυνσης των διακρίσεων με βάση τη φυλή, το έθνος ή το φύλλο. Η διαδικασία αυτή είναι κεντρικά συνδεδεμένη με τη διανομή αγαθών και υπηρεσιών στην κοινωνία, όπως η εκπαίδευση, η στέγαση και άλλα ανθρώπινα και πολιτικά δικαιώματα, τα οποία συχνά καθορίζονται πλέον από το λογισμικό ή από αλγοριθμικά εργαλεία λήψης αποφάσεων, τα οποία μπορεί να έχουν την δημοφιλή περιγραφή “τεχνητή νοημοσύνη”.

Το ερώτημα είναι πόσο συνειδητοί είναι αυτοί οι πολίτες και οι δημόσιες αρχές που αγοράζουν, αναπτύσσουν και χρησιμοποιούν τα συστήματα αυτά. Η περίπτωση της Σάλτα και πολλών άλλων μας δείχνουν ρητά ότι η λογική της προώθησης μεγάλων δεδομένων ως λύσης σε μια αδιανόητη σειρά κοινωνικών προβλημάτων εξάγεται στη Λατινική Αμερική, ενισχύοντας τις προκλήσεις της αποαποικιοποίησης. Αυτή η λογική όχι μόνο προσπαθεί να επικρίνει το στάτους κβο σε όλα τα πεδία των σχέσεων εξουσίας, από τη γεωπολιτική, μέχρι τα πρότυπα φύλου και τον καπιταλισμό, αλλά δυσχεραίνει επίσης τη διατήρηση και προώθηση εναλλακτικών τρόπων ζωής.

ΤΝ, φτώχεια και στίγμα

“Το μέλλον είναι σήμερα.” Αυτό φαίνεται να είναι το μάντρα, όταν οι δημόσιες Αρχές υιοθετούν με ανυπομονησία τις ψηφιακές τεχνολογίες, χωρίς να λαμβάνουν υπόψη τις επικριτικές φωνές, που δείχνουν ότι τα αποτελέσματά τους είναι ενδεχομένως υπέρ των διακρίσεων. Τα τελευταία χρόνια, για παράδειγμα, η χρήση μεγάλων δεδομένων για την πρόβλεψη της αστυνόμευσης φαίνεται ότι είναι μια δημοφιλής τάση στη Λατινική Αμερική. Στην έρευνά μας διαπιστώσαμε ότι διάφορες μορφές αυτών των συστημάτων ΤΝ έχουν χρησιμοποιηθεί (ή πρόκειται να αναπτυχθούν) σε χώρες όπως η Αργεντινή, η Βραζιλία, η Χιλή, η Κολομβία, το Μεξικό και η Ουρουγουάη [23], μεταξύ άλλων. Το πιο συνηθισμένο μοντέλο είναι η κατασκευή προγνωστικών χαρτών εγκληματικότητας, αλλά έχουν καταβληθεί επίσης προσπάθειες για την ανάπτυξη προγνωστικών μοντέλων πιθανών δραστών εγκλημάτων.

Όπως προτείνει [24] η Fieke Jansen:

Αυτά τα μοντέλα πρόβλεψης βασίζονται στην υπόθεση ότι όταν οι υποκείμενες κοινωνικές και οικονομικές συνθήκες παραμένουν ίδιες, το έγκλημα εξαπλώνεται καθώς η βία ενθαρρύνει κι άλλη βία ή ο δράστης πιθανώς θα διαπράξει παρόμοιο έγκλημα στον ίδιο τομέα.

Πολλοί επικριτές επισημαίνουν τις αρνητικές επιπτώσεις της πρόβλεψης της αστυνόμευσης στις φτωχότερες γειτονιές και σε άλλες πληγείσες κοινότητες, συμπεριλαμβανομένης της κακομεταχείρισης [25] της αστυνομίας, του στιγματισμού, του ρατσισμού και των διακρίσεων. Επιπλέον, ως αποτέλεσμα πολλών επικρίσεων, στις ΗΠΑ, όπου αυτά τα συστήματα έχουν αναπτυχθεί για κάποιο χρονικό διάστημα, πολλές αστυνομικές υπηρεσίες επανεξετάζουν την πραγματική αποτελεσματικότητα των συστημάτων [26].

Η ίδια λογική πίσω από την πρόβλεψη της αστυνόμευσης βρίσκεται στα συστήματα ΤΝ κατά της φτώχειας που συλλέγουν δεδομένα για την πρόβλεψη των κοινωνικών κινδύνων και την ανάπτυξη κυβερνητικών προγραμμάτων. Όπως έχουμε δει, αυτό συμβαίνει στην περίπτωση της Τεχνολογικής Πλατφόρμας για την Κοινωνική Παρέμβαση. Αλλά είναι επίσης παρούσα σε συστήματα όπως η Alerta Infancia (Σύστημα Παιδικής Ειδοποίησης) στη Χιλή. Και πάλι, σε αυτό το σύστημα, οι προβλέψεις των δεδομένων εφαρμόζονται σε ανηλίκους σε φτωχές κοινότητες. Το σύστημα αποδίδει βαθμολογίες κινδύνου στις κοινότητες, δημιουργώντας αυτοματοποιημένες προειδοποιήσεις προστασίας, οι οποίες στη συνέχεια επιτρέπουν “προληπτικές” παρεμβάσεις. Σύμφωνα με επίσημες πληροφορίες [27], αυτή η πλατφόρμα καθορίζει τον δείκτη κινδύνου από παράγοντες όπως η εφηβική εγκυμοσύνη, η προβληματική χρήση οινοπνεύματος ή / και ναρκωτικών, η εγκληματικότητα, οι χρόνιες ψυχιατρικές ασθένειες, η παιδική εργασία και η εμπορική σεξουαλική εκμετάλλευση, η κακομεταχείριση και η εγκατάλειψη του σχολείου. Μεταξύ των πολυάριθμων επικρίσεων του συστήματος, οι ομάδες της κοινωνίας των πολιτών που ασχολούνται με τα δικαιώματα των παιδιών δήλωσαν ότι, πέρα από την επιτήρηση, το σύστημα “συνιστά την επιβολή μιας ορισμένης μορφής κοινωνικοπολιτιστικής νομιμοποίησης”, καθώς και “ενθάρρυνση και κοινωνική επικύρωση μορφών στιγματισμού, ποινικοποίηση της πολιτιστικής πολυμορφίας που υπάρχει στη Χιλή”.

Όπως τόνισαν [28]:

Αυτό επηρεάζει ιδιαίτερα τους αυτόχθονες πληθυσμούς, τους πληθυσμούς των μεταναστών και τους κατοίκους με χαμηλότερα οικονομικά εισοδήματα, αγνοώντας ότι η αυξανόμενη πολιτιστική ποικιλομορφία απαιτεί μεγαλύτερη ευαισθησία, ορατότητα και σεβασμό, καθώς και τη συμπερίληψη προσεγγίσεων πολιτιστικής σημασίας στις δημόσιες πολιτικές.

Υπάρχουν τουλάχιστον τρία κοινά χαρακτηριστικά σε αυτά τα συστήματα που χρησιμοποιούνται στη Λατινική Αμερική, τα οποία είναι ιδιαίτερα ανησυχητικά, δεδομένης της δυνατότητάς τους να αυξήσουν την κοινωνική αδικία στην περιοχή: η μία είναι η ταυτότητα που επιβάλλεται σε φτωχά άτομα και πληθυσμούς. Αυτή η ποσοτικοποίηση του εαυτού, των σωμάτων (κατανοημένων ως κοινωνικά κατασκευασμένων) και των κοινοτήτων δεν έχει περιθώρια για επαναδιαπραγμάτευση. Με άλλα λόγια, η επεξεργασία δεδομένων αντικαθιστά την “κοινωνική ταυτότητα” με την “ταυτότητα του συστήματος”.

Σχετικά με αυτό το σημείο, υπάρχει ένα δεύτερο χαρακτηριστικό που ενισχύει την κοινωνική αδικία: η έλλειψη διαφάνειας και λογοδοσίας στα συστήματα αυτά. Κανένα από αυτά δεν έχει αναπτυχθεί μέσω μιας συμμετοχικής διαδικασίας οποιουδήποτε τύπου, είτε περιλαμβάνει ειδικούς είτε, ακόμη πιο σημαντικό, επηρεαζόμενες κοινότητες. Αντίθετα, τα συστήματα ΤΝ φαίνεται να ενισχύουν τις δημόσιες πολιτικές “από πάνω προς τα κάτω” από τις κυβερνήσεις που κάνουν τους ανθρώπους “δικαιούχους” ή “καταναλωτές”: “Όπως ανέφερε το Hacking ‘στην κατάταξη των ανθρώπων’ με ταξινόμηση, η δεδομενοποίηση ‘φτιάχνει’ τους δικαιούχους μέσω κατηγοριών απογραφής που κρυσταλλώνονται μέσω δεδομένων και γίνονται δεκτοί σε έλεγχο από πάνω προς τα κάτω.”

Τέλος, τα συστήματα αυτά αναπτύσσονται σε αυτό που θα αποκαλούσαμε “νεοφιλελεύθερες κοινοπραξίες”, όπου οι κυβερνήσεις αναπτύσσουν ή αγοράζουν συστήματα ΤΝ που αναπτύσσονται από τον ιδιωτικό τομέα ή από πανεπιστήμια. Αυτό αξίζει περαιτέρω διερεύνηση, καθώς οι νεοφιλελεύθερες αξίες φαίνεται να διαπερνούν το σχεδιασμό των συστημάτων ΤΝ, όχι μόνο από εταιρείες, αλλά και από πανεπιστήμια [29] που χρηματοδοτούνται από δημόσιους πόρους που προορίζονται για την “καινοτομία” και τη βελτίωση του εμπορίου.

Γιατί ένα τρανσφεμινιστικό πλαίσιο;

Όπως είδαμε, σε αυτά τα παραδείγματα χρήσης αυτών των τύπων τεχνολογιών, ορισμένα κυβερνητικά προγράμματα κατά της φτώχειας στη Λατινική Αμερική αντικατοπτρίζουν ένα θετικό πλαίσιο σκέψης, όπου η πραγματικότητα φαίνεται να είναι καλύτερα κατανοητή και να αλλάζει για το καλό εάν μπορούμε να ποσοτικοποιήσουμε κάθε πτυχή της ζωής μας. Αυτή η λογική προάγει επίσης το όραμα ότι αυτό που οι άνθρωποι θα αναζητήσουν είναι η “πρόοδος”, που θεωρείται συνώνυμο της αυξημένης παραγωγής και κατανάλωσης και τελικά σημαίνει εκμετάλλευση των οργανισμών και των εδαφών.

Όλοι αυτοί οι αριθμοί και οι μετρήσεις για τη ζωή των μη προνομιούχων ανθρώπων συλλέγονται, καταρτίζονται και αναλύονται με τη λογική της “παραγωγικότητας” για να διατηρήσουν τελικά τον καπιταλισμό, την ετεροπατριαρχία, την λευκή υπεροχή και την αποικιοκρατία. Ακόμη και αν η αφήγηση του “ποσοτικοποιημένου εαυτού” φαίνεται να επικεντρώνεται στο άτομο, δεν υπάρχει περιθώριο για αναγνώριση όλων των διαφορετικών στρωμάτων που μπορεί να φτάσει η ανθρώπινη συνείδηση, ούτε χώρος για εναλλακτικούς τρόπους ύπαρξης ή προαγωγής κοινοτικών πρακτικών.

Είναι απαραίτητο να συνειδητοποιήσουμε πώς δημιουργούμε μεθοδολογικές προσεγγίσεις στην επεξεργασία δεδομένων ώστε να αμφισβητήσουμε αυτά τα θετικά πλαίσια ανάλυσης και την κυριαρχία των ποσοτικών μεθόδων που φαίνονται να αποκτούν βασική εστίαση στην εξέλιξη και ανάπτυξη των αλγορίθμων του σήμερα και των διαδικασιών κατασκευής αυτοματοποιημένης απόφασης.

Όπως λέει η Silvia Rivera Cusicanqui:

Πώς γίνεται το αποκλειστικό, εθνοκεντρικό “εμείς” να διατυπωθεί με το ανοιχτό “εμείς” – μια πατρίδα για όλους – που οραματίζεται την αποαποικιοποίηση; Πώς σκεφτήκαμε και προβληματιστήκαμε, εδώ και τώρα, για το αποικισμένο παρόν και την ανατροπή του;

Πέρα από ένα πλαίσιο για τα ανθρώπινα δικαιώματα, οι αποαποικιακές και τρανσφεμινιστικές προσεγγίσεις στις τεχνολογίες είναι εξαιρετικά εργαλεία για να οραματιστούμε εναλλακτικά μέλλοντα και να ανατραπεί η επικρατούσα λογική, στην οποία αναπτύσσονται τα συστήματα ΤΝ. Οι τρανσφεμινιστικές αξίες πρέπει να ενσωματωθούν σε αυτά τα συστήματα, οπότε οι εξελίξεις στην ανάπτυξη της τεχνολογίας μας βοηθούν να κατανοήσουμε και να σπάσουμε αυτό που η Μαύρη φεμινίστρια και μελετητής Patricia Hill Collins αποκαλεί “μήτρα της κυριαρχίας” (αναγνωρίζοντας τα διαφορετικά επίπεδα καταπίεσης που προκαλούνται από τη φυλή, τη θρησκεία και άλλες πτυχές της διαθεματικότητας). Αυτό θα μας οδηγήσει σε ένα μέλλον που θα προάγει και θα προστατεύει όχι μόνο τα ανθρώπινα δικαιώματα, αλλά και την κοινωνική και περιβαλλοντική δικαιοσύνη, διότι και τα δύο βρίσκονται στον πυρήνα των αποαποικιακών φεμινιστικών θεωριών.

Επαναπροσδιορίζοντας το μέλλον

Για να προωθήσουμε αυτήν την φεμινιστική προσέγγιση στην πράξη, το Rights Coding, σε συνεργασία με το Co-Design Studio του MIT [30], πειραματίζεται με ένα παιχνίδι [31] που ονομάζουμε “Μάντης για Τρανσφεμινιστικά Μέλλοντα”. Μέσα από μια σειρά εργαστηρίων, όλοι μαζί είχαμε ιδέες για το τι είδους εμπρηστικές τρανσφεμινιστικές αξίες θα μας εμπνεύσουν και θα μας βοηθήσουν να φανταστούμε υποθετικά μέλλοντα. Όπως είπε κάποτε η Ούρσουλα Λε Γκουίν:

Το θέμα της επιστημονικής φαντασίας είναι, ότι δεν αφορά πραγματικά το μέλλον. Πρόκειται για το παρόν. Αλλά το μέλλον μας δίνει μεγάλη ελευθερία φαντασίας. Είναι σαν ένας καθρέφτης. Μπορείτε να δείτε το πίσω μέρος του κεφαλιού σας.

Πράγματι, απτές προτάσεις για αλλαγή στο παρόν εμφανίστηκαν, μόλις αφεθήκαμε να φανταστούμε το μέλλον στα εργαστήρια. Με την πάροδο του χρόνου, στις συναντήσεις προέκυψαν αξίες όπως η αυτενέργεια, η λογοδοσία, η αυτονομία, η κοινωνική δικαιοσύνη, οι μη δυαδικές ταυτότητες, η συνεργασία, η αποκέντρωση, η συγκατάθεση, η ποικιλομορφία, η αποαποικιοποίηση, η ενσυναίσθηση, η ασφάλεια.

Αν αναλύσουμε μόνο μία ή δύο από αυτές τις αξίες, σε συνδυασμό [32], μας δίνεται ένα εργαλείο για να αξιολογήσουμε τον τρόπο, με τον οποίο ένα συγκεκριμένο έργο ή ανάπτυξη της ΤΝ κατατάσσεται σε ένα αποαποικιακό φεμινιστικό πλαίσιο αξιών. Βάσει αυτού μπορούμε να προτείνουμε εναλλακτικές τεχνολογίες ή πρακτικές που είναι πιο συνεκτικές, δεδομένου του παρόντος και του μέλλοντος που θέλουμε να δούμε.